Forbløffende bilder og illustrasjoner laget av datamaskiner er noe av det mest spennende som har skjedd på teknologifronten det siste året. Vi ble fristet til å gjøre et artig eksperiment.

Det finnes nå datasystemer som gjør at du kan skrive hva du vil i en tekstboks, og så få laget et bilde. Utviklingen på dette feltet har gått utrolig fort. For å vise det aller siste steget laget vi et eksperiment med ansiktene til Thomas Seltzer, Annika Momrak og Selda Ekiz.

Først spurte vi om lov til å bruke noen få bilder av dem til å trene opp en datamodell. Så brukte vi et system kalt «Stable Diffusion» til å lage programvare vi kunne benytte for å skape helt nye og maskingenererte bilder av ansiktene deres.

Resultatet er noen ganger sjokkerende bra. Andre ganger meget dårlig og rart til det absurde.

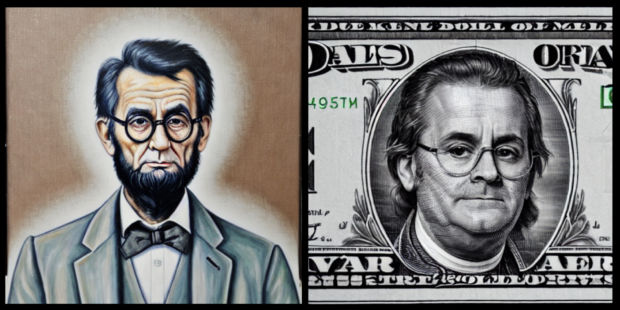

Abraham Seltzer og andre amerikanske varianter

Thomas Seltzer var førstemann vi tok kontakt med. Programlederen, musikeren og forfatteren svarte entusiastisk og ville være med. Han mente at dette ville bli et spennende eksperiment. For ham bestemte vi oss for å se om vi kunne trene modellen basert på bilder som vi fant av ham på nett.

Bildene viste seg gode nok, så da var det bare å sette igang. Siden Seltzer har vært aktuell med en ny sesong av serien UXA denne høsten ble det fristende å lage litt USA-relatert innhold med det kjente ansiktet.

Stable Diffusion kan etterligne stilen til en rekke kunstnere og benytte seg av mer generelle teknikker. Det var ingen tvil om at den nye modellen vi laget nå også kunne gjenskape ansiktstrekkene til Seltzer.

Men vi klarte ikke helt å gi oss med amerikagreiene. Så vi ba om «An old portrait of a civil war hero Thomas Seltzer». Fotografiet vi fikk er forbausende bra for å være et bilde som skulle være tatt for mer enn 150 år siden.

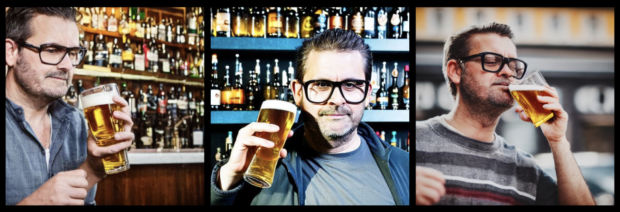

Så ba vi maskinen om å prøve å lage mer fotorealistiske nåtidsbilder av Seltzer, for eksempel på bar. Da avslørte datamodellen at den fremdeles har noen utfordringer. Særlig med hender.

Da hovedpersonen fikk oversendt bildene fra den falske baren så han både humor og potensielt skremmende muligheter.

— Hahaha, dette ble mer shallow fake enn deep fake, si! Kunstig intelligens er enn så lenge konstig intelligens, hvert fall når det gjelder grafikk og musikk. Men på litt større sikt så er dette creepy as fuck, tommel ned herfra. Men ooops, der forsvant tommelen, gitt…

- Ved å trene opp datamaskiner på flere millioner bilder kombinert med avanserte språkmodeller har man klart å lage systemer som kan generere visualiseringer basert på ren tekst.

- De mest kjente er Stable Diffusion, Dall-E og Googles system som heter Imagen.

- Alle baserer seg på såkalte diffusjonsmodeller. Maskinen får servert bilder av høy kvalitet som så blir kombinert med tekstmodeller. Deretter fjerner systemet trinn for trinn informasjon fra bildene slik at programvaren trenes opp til å kjenne igjen de enkleste og tydeligste egenskapene i alle bildene.

- Prosessen kan så reverseres og programvaren klarer å lage illustrasjoner basert på analyse av teksten den får som input.

- Mye av teknologien er basert på åpen kildekode slik at man også kan trene modellene selv.

- Det er for tiden en del kontrovers rundt denne teknologien. Blant annet fordi det settes spørsmålstegn ved opphavsrett og bruk av bilder for å trene modellene.

- Det foregår også en heftig diskusjon om hvorvidt illustratører, kunstnere og fotografer kan miste jobben på grunn av teknologi som dette.

En mislykket Yoda

Annika Momrak er kjent for mange fra NRKs «Fjerde etasje» og som en av programlederne for MGP nå i vår. Hun svarte litt spøkefullt da vi tok kontakt for å høre om vi kunne få leke med bilder av henne.

— Ja, kjempekult! Er det noe jeg vil låne ut ansiktet mitt til så er det jo dette!

For å trene opp modellen trengte vi 5-10 bilder av ansiktet. Så Momrak kom innom hos oss i NRKbeta og ble fotografert.

For Momrak ble resultatene ikke like tydelige som for Seltzer. Da vi ba om bilder av henne ble det mye generelle bilder hvor det var vanskeligere å se tydelige trekk av Momrak.

Da Momrak fikk se bildene ble hun både litt overrasket og tankefull.

— Det er på en måte som å se seg selv utenfra. Jeg kjenner igjen trekk, men det er også mye som ikke stemmer.

Vi ble raskt enige om at det var det særdeles mislykkede forsøket på å fremstille Momrak som Star Wars-figuren Yoda som var de morsomste bildene.

Da vi eksperimenterte med disse modellene og prøvde å få en bedre forståelse av hvordan de virker var det interessant å se hvor forskjellig de klarte å lære ulike ansikter.

En utslitt astronaut

Selda Ekiz hadde et helt spesifikt ønske da vi hadde trent modellen med bilder av henne. Hun ville se seg selv som skurken The Joker fra Batman-filmene.

Det ordnet vi, og Ekiz både lo og ble litt skremt.

— Wow! Se der ja. Jeg føler meg litt som en sliten The Joker av og til. Men ok, det der var også ganske scary. Det blir neste Halloween-kostyme!

For Ekiz hadde modellen klart å ta tak i noen ansiktstrekk som skinner gjennom på flere av bildene.

Bildene varierte hele veien fra ung til gammel, og fra trøtt til opplagt. Ekiz selv fant det stort sett bare fascinerende og lot fantasien løpe løpsk.

— Haha. Det der er meg som en litt eldre og utslitt astronaut som nettopp har kommet ned på jorden etter en strabasiøs ferd.

Gjør det selv

Det er enkelt å teste selve hovedmodellen som kan lage bilder av nesten hva som helst, men det å lage en modell av egne bilder er litt mer komplisert. En av de beste oppskriftene vi har funnet er Tarunabh Dutta sin ganske detaljerte gjennomgang. Men det hele krever litt over middels forståelse for datamaskiner og nett-tjenester.

Det nærmeste vi kommer en tydelig og brukervennlig løsning akkurat nå er selskapet Prisma Labs sin app som heter Lensa AI. Du får ikke full frihet til å lage egne beskrivelser av det du vil ha, men det de kaller «Magic Avatars» minner veldig om mye av det vi har laget ved hjelp av Stable Diffusion. Det vi uansett kan si med sikkerhet er at denne teknologien blir bedre, billigere og mer tilgjengelig for hver måned som går.