Kommentar: Flere elever ved studieprogrammet International Baccalaureate (IB) fikk i år vesentlig lavere karakterer enn forventet. Resultatene ble bestemt av en bedømmingsmodell i en datamaskin. Det viste seg problematisk. Makinene tar viktigere og viktigere valg for oss. Snart handler dette om oss alle.

Etter at elevene klagde og blant annet fikk advokathjelp ble modellen endret. IBs sentrale organisasjon IBO vil ikke avsløre nøyaktig hvordan systemet fungerer, men opplyser at det blant annet baserer seg på elevenes større skriftlige arbeid, forventninger fra lærerne og historiske resultater fra skolen.

Etter nærmere gransking kan det vise seg at løsningen kanskje er ulovlig. I Storbritannia opplevde de en tilsvarende situasjon i år da svært mange avgangselever fikk dårligere karakterer enn forventet. Der endte de med å gå helt vekk fra de beregnede karakterene og brukte karakterer satt av lærerne i stedet.

Likevel er nok dette noe vi bare kommer til å se mer av.

Ofte kalles komplekse datamodeller for algoritmer. Og det blir bare vanskeligere og vanskeligere å gjøre rede for hvordan de fungerer.

Det sosiale mediet du bruker hver dag? Styres av algoritmer. Søkeresultatene på nett? Styres av algoritmer. Avslag på lånesøknad? Ble styrt av en algoritme. Det kan være mange grunner til å ikke oppgi nøyaktig hvordan de virker. Konkurransehensyn og datasikkerhet er to av dem.

Ansvarsfraskrivelse

Det som er viktig er at bruken av komplekse datamodeller ikke bare blir en ansvarsfraskrivelse. På en måte er det fascinerende at definisjonen av en algoritme nærmest er en nøyaktig beskrivelse av noe som det burde være enkelt å forklare:

«En algoritme er innen matematikk og informatikk en presis beskrivelse av en endelig serie operasjoner som skal utføres for å løse et problem eller flere problemer.»

Likevel får jeg noen ganger følelsen av at definisjonen er:

«Et skikkelig komplekst datasystem som ingen har oversikt over og som derfor er helt umulig å forklare.»

“Retten til en forklaring” er diskusjonen rundt akkurat dette. En diskusjon som fikk fart da den sinte storebroren til algoritmen dukket opp. Nemlig maskinlæring og kunstig intelligens.

Forvirret og skremt

Om vi løfter blikket og ser litt inn i fremtiden kommer vi til det som gjør folk både fascinert og skremt når jeg underviser og holder foredrag om kunstig intelligens. Det er det tidspunktet der datamaskinen blir smartere enn oss mennesker. Det tidspunkt som også kalles teknologisk singularitet.

Da kommer den smarte datamaskinen til å lage en ny datamaskin som er enda smartere. Som så kommer til å lage en som er enda smartere enn det igjen.

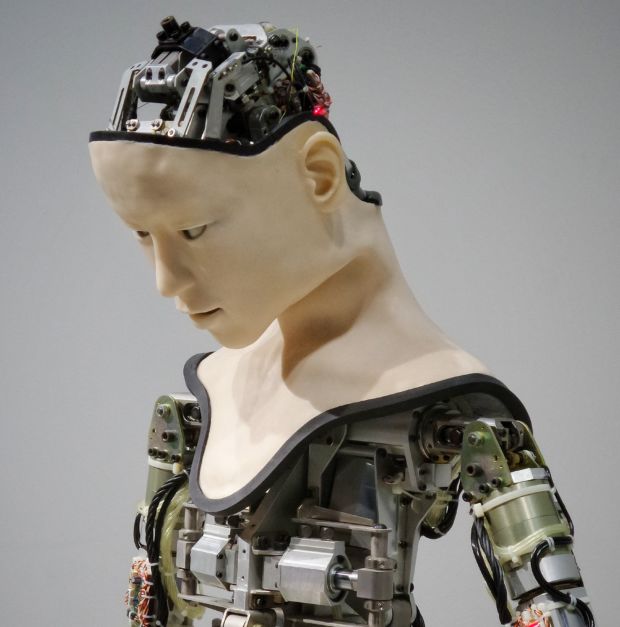

Foto: Franck V. fra Unsplash

Fremtiden er her allerede

En av teoriene rundt teknologisk singularitet er at vi da innen kort tid kommer vi til å ha en datamaskin som ser på menneskets intellektuelle kapasitet slik vi ser på evnene til en middels smart grevling i dag. Den datamaskinen vet at vi ikke skjønner bæret av hva den holder på med.

På det tidspunktet er det viktig at vi har rigget oss riktig med både regler og etisk programmering av maskinene.

Det var ikke superintelligente fremtidsdatamaskiner som satte karakterer nå, men diskusjonen om hvem som har ansvaret må vi ta allerede. Er det dem som laget algoritmen? Vi har allerede algoritmer som lager nye algoritmer. Når blir det umulig å spore ansvaret tilbake?

Det som også er skummelt er at helt siden kalkulatoren ble oppfunnet har datamaskiner gitt inntrykk av å gi objektive beslutninger. Fordi vi i stor grad har brukt dem til matematiske beregninger der maskinen kan sette to streker under svaret.

Ikke nødvendigvis objektiv

Nå bruker vi dem til så mye mer. Og avgjørelsene er så uendelig mye mer komplekse enn at to pluss to blir fire.

Vi er på vakt når mennesker tar avgjørelser. Har læreren latt seg påvirke av elevens sjarm og ikke kun sett på resultatene? Har bedriftslederen latt seg påvirke av kandidatenes hudfarge og ikke kun sett på kvalifikasjoner?

Vi må lære oss å bli like kritiske til maskinene. Og da må vi få vite hvordan de tar avgjørelser. “Retten til en forklaring” kommer til å bli en meget viktig del av personvernet fremover.

Datamaskiner er allerede overlegne når det gjelder å gjøre komplekse og avanserte beregninger fort. Men da må vi ha bedre modeller enn det IB-studentene og avgangselevene i Storbritannia ble utsatt for nå.